知乎:PENG Bo

链接:https://www.zhihu.com/question/666991594/answer/3624168868

大家都知道长期CoT可以提升性能,而且很快我们会看到其它家的例子,这是最后的low-hanging fruit,因为只需合成大量训练数据,包括动态去合成有针对性的训练数据。

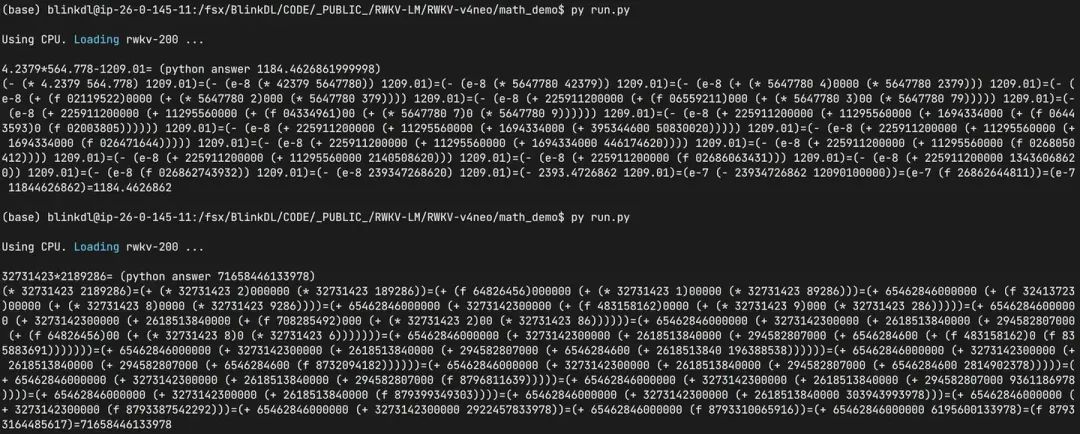

例如,我去年7月演示过,一个2.9M参数量的超小RWKV-4配合长期CoT可以精确解决各种复杂四则运算:

https://github.com/BlinkDL/RWKV-LM/tree/main/RWKV-v4neo/math_demo (训练数据合成时覆盖不够全面,数字别写太长太多,但可以随意换其它随机数字)

如果用RWKV这样的RNN模型,无论做多久的CoT,消耗的显存,和生成每个字的速度,都是恒定的,因此尤其适合做长期CoT。相当于在state的潜空间做长期的行走。

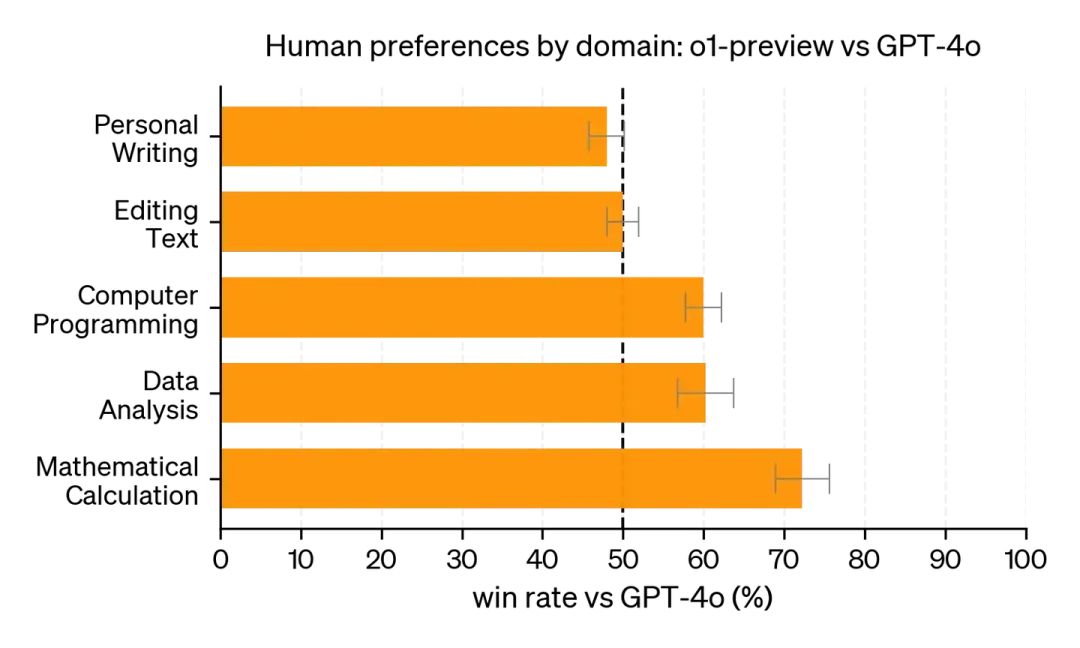

数学和代码,尤其适合通过这种方法提升。而且还可以配合MCTS。而且模型可以调用外部工具验证,可以自己纠错(这个看上去还没开放,估计因为OAI认为目前对于公众开放这种就显得过于强)。

我一直认为,这个方法一直做下去,足够做到"伪AGI",替代99+%的人类工作。因为人类在99+%的时候没有智能。

然后,水涨船高,大家会习以为常,这会commoditize。

剩下的才是真正有趣的问题,例如真正的创意,真正的洞察力,超越时代的想法,在没有路的地方走出路来,也包括真正的感悟和体验,因为这些事情的验证标准是不明确的。

人类是怎么想到这些事情的,是目前的大模型无法理解的。就像,拉马努金说他是梦到的。

当然,这些也有办法解决,只不过,如果知道的人不说,不知道的人(或模型)就不可能想出来。

例如,写作是最简单的,又是最难的。

这就像什么呢?就像一直有很多人爱吹OAI,就像高赞回答爱吹。因为,太多的事物,在不懂的人看来是神奇的(因为他们不可能想出来),在懂的人看来是trivial的(因为不用想就知道)。

令人遗憾的现实是:不懂的人,做再多CoT,也是不可能懂的。所以CoT不是万灵药。