模型压缩优化方向:

●减少内存密集的访问量

●提高获取模型参数的时间

●加速模型推理时间

模型压缩方法包括:

●模型量化(Data Quantization),

●模型稀疏化(Model sparsification,也叫 Model Pruning),

●知识蒸馏(Knowledge Distillation),

●轻量化模型设计(Lightweight Network Design)

●张量分解(Tensor Decomposition)。

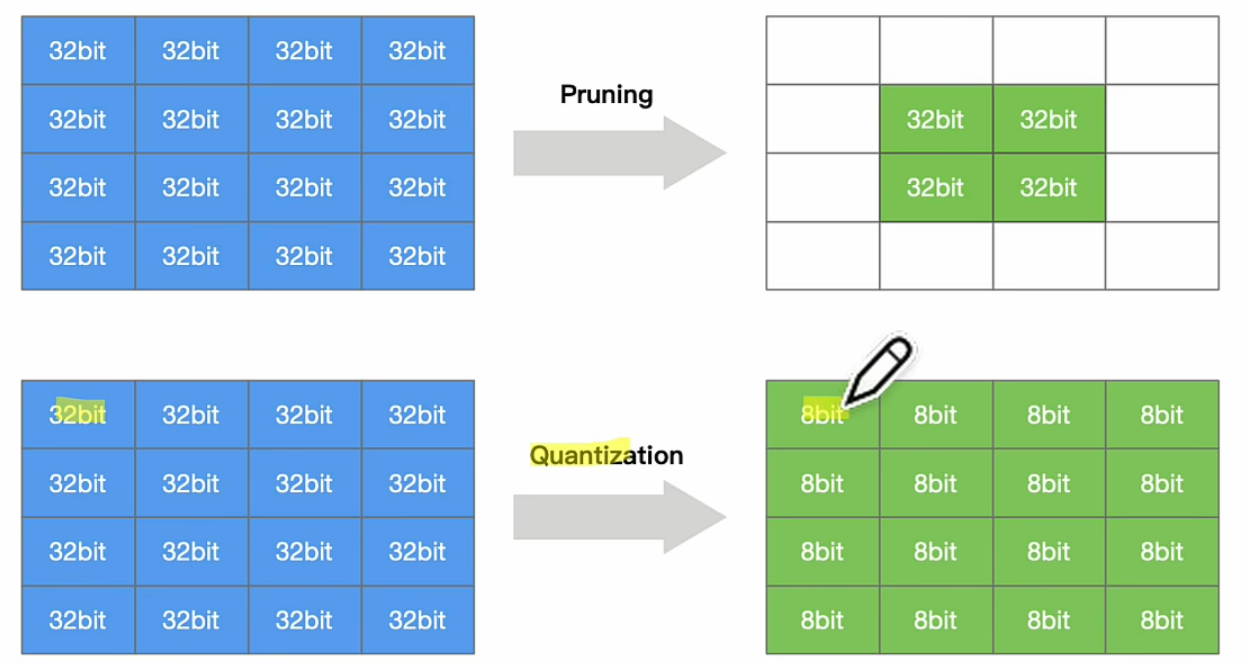

模型量化是指减少权重表示或者激活所需的比特数来压缩模型;

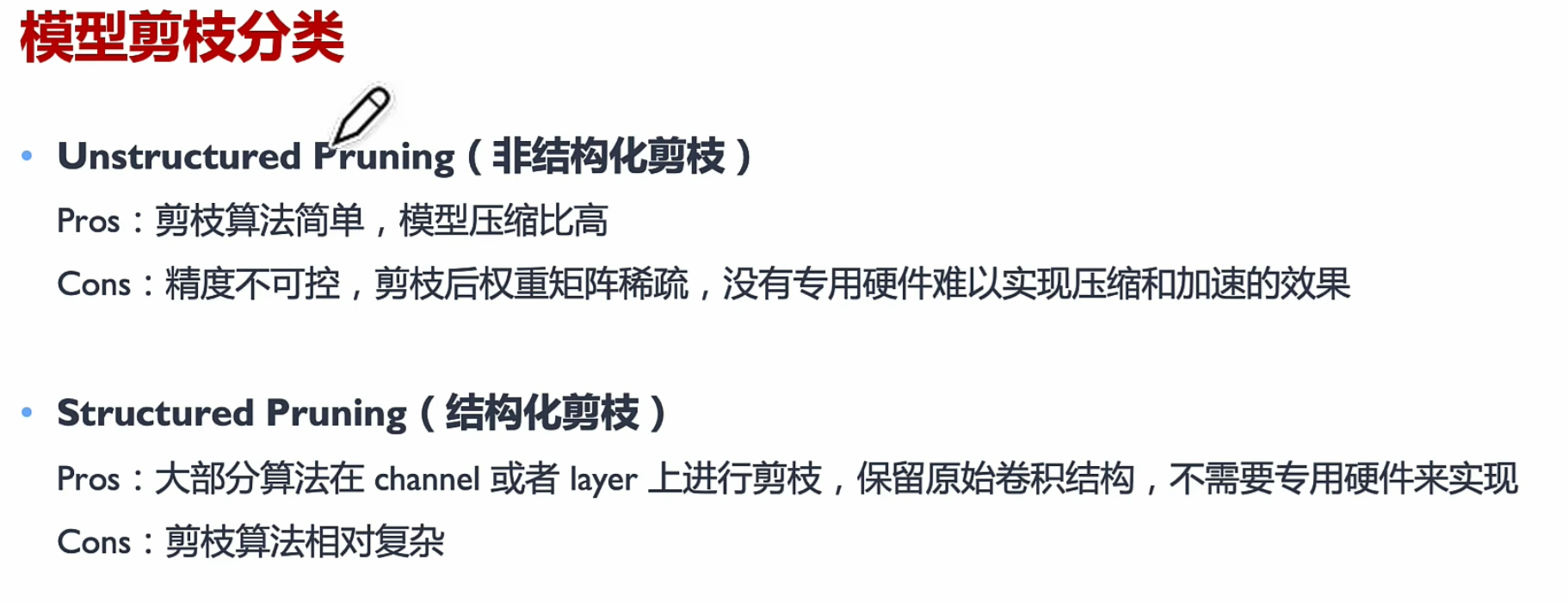

模型剪枝研究模型权重中冗余,并尝试删除/修剪冗余和非关键的权重;